Modelos de código abierto

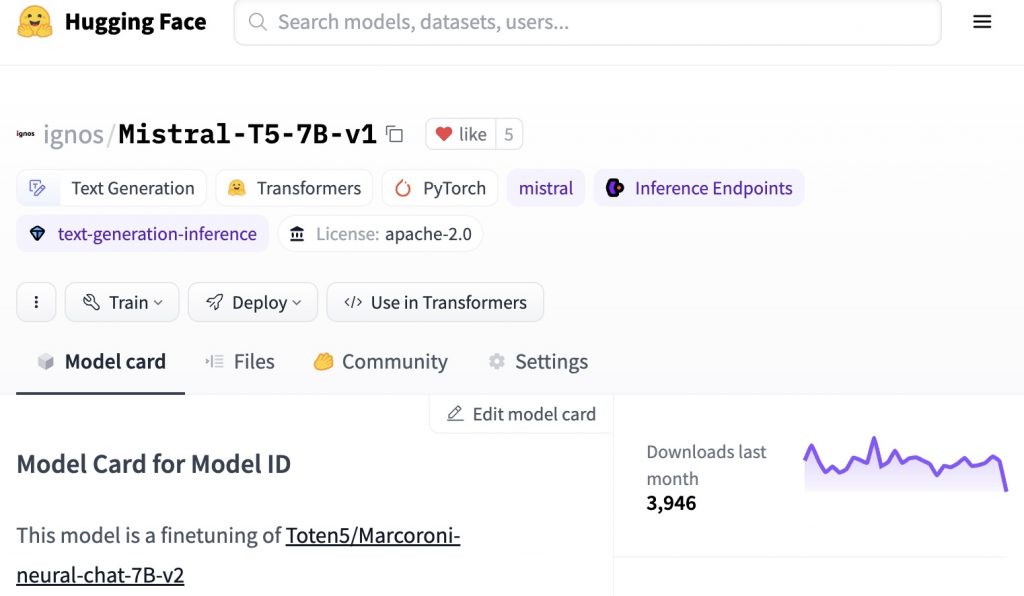

Ignos, dentro de sus actividades de I+D en el ámbito de la Inteligencia Artificial, ha desarrollado un nuevo LLM basado en la arquitectura Mistral bajo el paradigma de software libre. Este modelo, que ha logrado puntuaciones elevadas dentro del Leaderboard de Hugging Face, ha demostrado que puede ser una ayuda importante en la mejora del comportamiento instructivo en sistemas de IA. En menos de un mes este modelo se ha descargado miles de veces para su evaluación e implantación en sistemas de IA de todo tipo.

Detalles del LLM

Desarrollo y Características

El modelo, una versión afinada del «Toten5/Marcoroni-neural-chat-7B-v2», ha sido desarrollado por Ignos. Se caracteriza por partir de un modelo «Mistral» y se distribuye bajo la licencia Apache-2.0, de manera que su uso no está limitado por restricciones de tipo comercial. La intención principal detrás de su creación es mejorar la conducta instructiva, lo que implica una mayor eficiencia y precisión en tareas de enseñanza y orientación automatizadas.

Sesgos, Riesgos y Limitaciones

Al igual que sus modelos base, este LLM de Ignos hereda los mismos sesgos, riesgos y limitaciones. Es crucial reconocer y abordar estos aspectos para garantizar una aplicación justa y ética del modelo, teniendo en cuenta el ámbito en el que será usado y el tipo de tareas generativas que se le requerirán.

Detalles del entrenamiento

Datos de entrenamiento

El modelo se entrenó utilizando el conjunto de datos «tatsu-lab/alpaca», conocido por su amplia variedad y calidad en el ámbito del procesamiento del lenguaje natural.

Procedimiento de entrenamiento

El entrenamiento se llevó a cabo mediante el enfoque QLoRA (Quantization and Low-Rank Adapters ) que son técnicas utilizadas para optimizar modelos de aprendizaje automático. La cuantización reduce la precisión de los números utilizados en el modelo (por ejemplo, pasando de 32 bits a 8 bits) disminuyendo el tamaño del modelo y aceleranado el cálculo, lo que es útil en dispositivos con recursos limitados. Los adaptadores de bajo rango, por otro lado, son pequeñas redes insertadas en un modelo preentrenado para ajustarlo a tareas específicas. Estos adaptadores, al ser de bajo rango, requieren menos parámetros, lo que reduce la complejidad sin sacrificar mucho rendimiento. Posteriormente, este modelo se fusionó con el modelo base, integrando así sus fortalezas y capacidades.

Especificaciones Técnicas del LLM

Arquitectura y Objetivo del Modelo

El LLM se basa en la Arquitectura Mistral, una estructura avanzada para modelos de lenguaje que aporta un procesamiento más eficiente y resultados más precisos.

Infraestructura de Cómputo

El entrenamiento se realizó en el proveedor de infraestructura en la nube RunPod, utilizando un entorno que incluye 3 tarjetas gráficas RTX 4090, 48 vCPUs y 377 GB de RAM. Esta configuración de hardware asegura un entrenamiento rápido y eficiente.

Software y Versiones de Framework

El software utilizado para el desarrollo incluyó Axolotl 0.3.0 y la versión 0.6.0 del framework PEFT. Estas herramientas son esenciales para el manejo eficiente de grandes cantidades de datos y complejas operaciones de aprendizaje automático.

Conclusión

El nuevo modelo LLM de Ignos, basado en la arquitectura Mistral, representa una herramienta de gran utilidad en sistemas de IA dentro del campo del procesamiento del lenguaje natural. Sus especificaciones técnicas y enfoque de entrenamiento avanzado sugieren un gran potencial para mejorar la interacción instructiva en aplicaciones de IA. Sin embargo, es vital abordar los sesgos y limitaciones heredados para garantizar una aplicación efectiva y ética en diversos contextos.

Si quieres adoptar soluciones basadas en IA para la gestión de datos en tu organización, no dudes en contactarnos.