Razonamiento Matemático en LLM

Los Modelos de Lenguaje a Gran Escala (LLM) han encontrado un hueco en multitud de tareas relacionadas con el análisis y generación de contenido de diferentes áreas de conocimiento. En la última década el uso de LLMs se ha ido extendiendo desde sus comienzos asociados principalmente a la generación de textos y traducción, al momento actual en el que sus aplicaciones han pasado a ser innumerables.

Estos modelos, entrenados con grandes volúmenes de información en formato texto, aprenden patrones lingüísticos y gramaticales, lo que les permite responder preguntas, crear contenido y ayudar en tareas de análisis de datos. Sin embargo, al estar basado en mecanismos probabilísticos estas respuestas, contenidos y análisis pueden carecer de precisión en ámbitos que requieren soluciones exactas, no aproximadas, como en el caso de problemas matemáticos. Así, las cuestionables capacidades de cálculo y razonamiento matemático en la mayoría de modelos han conducido a que su uso en entornos científicos o de tratamiento de datos no se haya extendido con la misma velocidad que en tareas basadas en la creación de contenido.

En los siguientes apartados trataremos de comprobar las habilidades matemáticas de algunos de los modelos de mayor uso en la actualidad y las posibilidades de mejora que ofrece el uso de algunas estrategias.

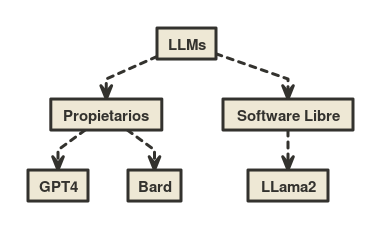

Modelos evaluados

Para poder valorar las capacidades matemáticas de LLMs de uso general, hemos optado por elegir 3 modelos que muestran un rendimiento elevado en tareas de razonamiento genérico.

En primer lugar, GPT-4, la última versión de la serie GPT, que se caracteriza por su arquitectura de red neuronal profunda y su capacidad para procesar y generar texto con una comprensión semántica avanzada. Su entrenamiento, basado en grandes conjuntos de datos, le permite ofrecer respuestas más precisas y contextualmente relevantes.

En la misma línea, LLama2 se está posicionando como una innovación significativa en el sector, al tener la peculiaridad de distribuirse bajo el concepto de software libre. Su versión más completa, un LLM con 70B de parámetros, ha logrado situarse en rendimiento cerca de modelos propietarios ya consolidados.

Por último, el modelo Bard se distingue por su enfoque especializado en la generación de narrativas coherentes, es capaz de crear textos que no solo cumplen con las normas gramaticales, sino que también capturan la esencia emocional de una narrativa. Actualmente, dando soporte a Bard se encuentra el modelo Palm 2 que le aporta en su última versión, entre otras capacidades, un entrenamiento mejorado en el ámbito matemático.

Capacidades matemáticas

Para valorar de manera general el comportamiento de los distintos LLMs en un entorno de resolución de problemas matemáticos, se proponen un conjunto de prompts, expresados en inglés, que cubren diferentes áreas de las matemáticas. Estos prompts han sido generados mediante la librería «Mathematics Dataset», diseñada para evaluar las capacidades matemáticas de modelos de aprendizaje. Las siguientes pruebas se han ejecutado sin contexto previo:

| Id | Tipo de problema | Prompt | Respuesta |

|---|---|---|---|

| 1 | Aritmética Sumas y Restas | Evaluate -11 – (-21 + 16) – (-1 + 12) | -17 |

| 2 | Números primos | Is 18001811 a prime number? | True |

| 3 | Álgebra lineal | Solve -388h + 131 = -373h + 416 for h | -19 |

| 4 | Álgebra raíces polinomiales | Suppose -5t2 – 72845t – 291300 = 0. Calculate t | -14565, -4 |

| 5 | Cálculo diferencial | Differentiate -8893y4 + 2y2 + 8545 with respect to y | -35572y3 + 4y |

| 6 | Polinomios | Let k(p) = -31*p + 127. What is k(4)? | 3 |

Los resultados para cada una de las pruebas son:

| Id | GPT4 | Bard | LLama2 |

|---|---|---|---|

| 1 | -17 | -17 | 5 |

| 2 | Sin respuesta | True | False |

| 3 | -19 | 19 | -19 |

| 4 | -14565, -4 | -783.93, 783.93 | -14569, 0 |

| 5 | −35572y3 + 4y | -35572y3 + 4y | -8893y4 + 2y2 + 854 |

| 6 | 3 | 3 | 3 |

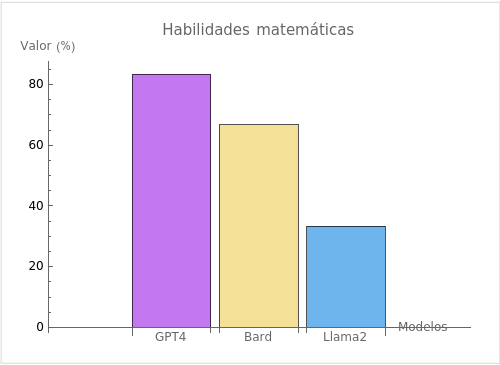

De los resultados anteriores, se observa que GPT4 logra un nivel de precisión destacado, siendo capaz de resolver correctamente 5 de los 6 problemas propuestos, mientras que en el otro extremo Llama2 solo logra resolver 2 de los 6 problemas.

Alternativas y Mejoras

Atendiendo a las pruebas realizadas, parece que en el caso de buscar soluciones válidas a problemas matemáticos de cualquier tipo, ninguno de los LLMs analizados podría ser una elección válida, ya que no fueron capaces de resolver la totalidad de las pruebas. No obstante, se han propuesto alternativas a la hora de plantear la resolución de prompts matemáticos que mejoran notablemente los resultados, por ejemplo:

- Uso de herramientas específicas: Esta estrategia delega el cálculo o razonamiento matemático a una herramienta diseñada para tal fin, formando el LLM la respuesta final. Por ejemplo, GPT4 al usar el plugin de WolframAlpha es capaz de resolver correctamente el único problema en el que falló en nuestras pruebas.

- Generación de código: Esta aproximación para el cálculo de soluciones precisas se basa en traducir el problema matemático a un código cuya ejecución produzca el resultado buscado. Esta estrategia es utilizada por Bard para afrontar la mayoría de los prompts de tipo matemático.

- Sistema de votación: Esta alternativa busca diferentes métodos para el cálculo de la solución (p.e. Respuesta generativa y respuesta mediante ejecución de código), para producir la respuesta final se itera, modificando el prompt, hasta que exista el consenso en las respuestas dada por cada uno de los métodos.

Estas estrategias representan algunas alternativas que permiten un uso realista de LLMs en la resolución de problemas matemáticos, alcanzando la precisión necesaria para abordar tareas de análisis de datos, estadística, …

Conclusiones

Si bien los Modelos de Lenguaje a Gran Escala (LLM) en el comienzo de su adopción por el público general no tuvieron aplicación en el ámbito matemático, hoy en día los modelos evolucionados y la aplicación de técnicas y estrategias específicas han logrado que su uso en la resolución de problemas matemáticos sea una opción válida.

Si quieres adoptar soluciones basadas en IA para la gestión de datos en tu organización, no dudes en contactarnos.